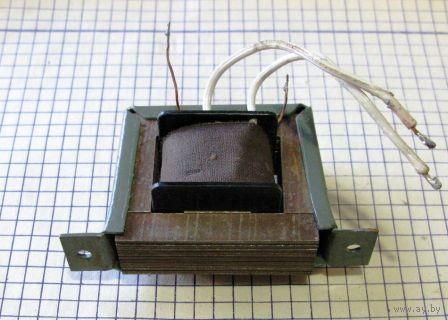

Трансформатор абонентский: Трансформатор абонентский ТАМУ-10 (10Вт) 240/30В купить в интернет магазине ООО Гарант

alexxlab | 28.03.2023 | 0 | Разное

Абонентський радіомовний трансформатор ТАМУ-10 – купити за найкращою ціною в Києві від компанії “МДК-Київ – ТЕНи на всяк смак…”

Опис

Радіомовний трансформатор абонентський ТАМУ-10. Артикул 4560, пк 129800

ТАМУ-10, ТАМУ-25, ТАМУ-50 — абонентські трансформатори потужністю 10Вт, 25Вт і 50Вт призначені для трипрограмного радіомовлення. Встановлюється на повітряних і змішаних лініях радіотрансляційних мереж проводового мовлення.

Трансформатори типу ТАМУ можуть випускатися в циліндричному або кубичном корпусі, з настінним кріпленням або з кріпленням для установки на трубу.

| Призначення, область застосування | харчування радіоліній (радиорозеток) одного під’їзду житлового будинку; установка в мережах проводового мовлення |

| Номінальна потужність | 10ВА |

| Номинальное напряжение первичной обмотки | 240В |

| Номинальное напряжение вторичной обмотки | 30В |

| Номинальное напряжение в состоянии поставки первичной обмотки | 240В±7% |

| Номинальное напряжение в состоянии поставки вторичной обмотки | 30В±7% |

| Технические характеристики | регулируемый зазор искрового разрядника: 0,3+0,1мм |

| Исполнение | климатическое: УХЛ1 |

| Условия эксплуатации | –45…+55°С, влажность: до 98% при +25°С; атмосферное давление не ниже 630 мм рт. ст ст |

Варианты маркировки / исполнения:

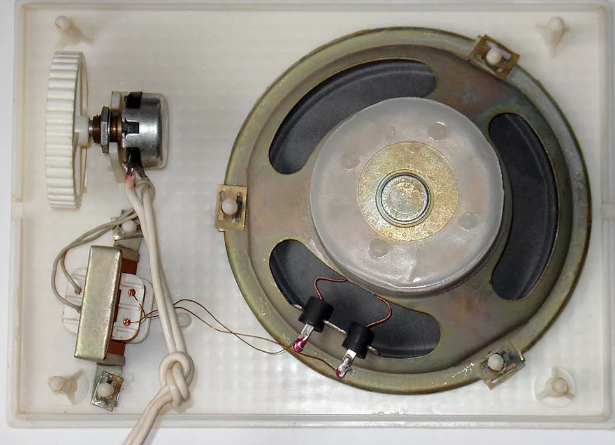

- Трансформатор абонентский 10Вт / пластиковый корппус

- ТАПВ-10С / стальной корпус

Доступные модификации

- Трансформатор ТАМУ-10 — 1061.76 грн., артикул 4560

- Трансформатор ТАМУ-25 — 1108.26 грн., артикул 2147

- Трансформатор ТАМУ-50 — 1987.20 грн., артикул 4942

Виробництво – Україна

| Ціни на даній сторінці вказані з урахуванням ПДВ |

|---|

Дивіться на нашому сайті інше обладнання та комплектуючі для проводового радіо …

○

○

○

○

○

У нас вы всегда можете купить или заказать ТЭН для электропечи, для барбекю, для гриля, для тостера, для бойлера, для проточного водонагревателя, для алюминиевого радиатора, для чугунной батареи, для полотенцесушителя, для утюга, для чайника, для самовара, для стиральной машины, для фритюра, для промышленной кухонной плиты или печи, блок ТЭНов для электрокотла, подобрать электроконфорку, а также терморегулятор и другой сопутствующий товар данного направления. Звоните прямо сейчас —

Звоните прямо сейчас —

многоканальный телефон:

044 501-02-88ТЭН ‘’под заказ’’ — изготовление электронагревательных элементов по вашим чертежам, эскизам и с требуемыми вам характеристиками.

Вы все еще ищете, где купить ТЭНы в Киеве?! Так мы вам подскажем — где можно купить ТЭН в Киеве! Причем, совсем недорого купить ТЭН в Киеве! И не просто дешево купить ТЭН в Киеве, а с заводской гарантией! Правильно — у нас, на улице Луговой, 9-Е

Характеристики

Інформація для замовлення

Трансформатор абонентский ТАПВ – 10 С/25 С

Товар сертифицирован

Выберите город:МоскваЕкатеринбургНовосибирскЛипецкНижний НовгородУфаСанкт-ПетербургВоронежРостов-на-ДонуСамараПермьКазаньТюменьОмскАстраханьСургутВолгоградКалининградВладивосток

Транспортной компанией

Доставка в Москву от 1-2 дней

Стоимость доставки: 2910 ₽*

*Ориентировочная стоимость за 1кг (куб. м)

м)

Гарантия и сервис

Гарантия 12 месяцев

Связаться с нашим менеджером и сообщить о неисправности

- Описание

- Отзывы(0)

Трансформатор абонентский ТАПВ – 10 С/25 С предназначен для установки на линиях радиотрансляционных сетей проводного вещания.

| Параметры | Значение |

| Номинальная мощность, ВА | 25 |

| Номинальное напряжение первичной обмотки, В | 240 |

| Номинальное напряжение вторичной обмотки, В | 30 |

| Ток холостого хода, А | 0,09 |

| Потери холостого хода, Вт | 3,3 |

| КПД трансформатора при номинальной нагрузке на частоте 1000 Гц | 0,9 |

Входное сопротивление Zвх на частоте, кОм:

| 5 10 |

Коэффициент передачи К на частоте

| 42 75 |

| Регулируемый зазор искрового разрядника, мм | 0,3+/-0,1 |

| Масса ТАПВ-10 С/25 С, кг | 1,9 |

Рекомендуемое оборудование и аналоги

Под заказ

Трансформатор напряжения IVD1-1.

1.1

1.1Купить

Под заказ

Трансформатор ТСУ

Купить

Под заказ

Трансформатор тока ТЗЛУ-70

Купить

Под заказ

Трансформатор тока ТЗЛУ-125

Купить

Под заказ

Трансформаторы ЗНМИ

Купить

Под заказ

Трансформатор ТПП

Купить

Под заказ

Тороидальный трансформатор

Купить

Под заказ

Трансформаторы ТСП, ТСП 1

Купить

Под заказ

Трансформатор ТВК-75

Купить

Под заказ

Трансформатор ТСТ

Купить

Под заказ

Трансформатор ТГМ 1020

Купить

Под заказ

Трансформатор ТрЗ 8-24

Купить

Под заказ

Трансформатор тока Т-0,66

Купить

Под заказ

Трансформатор тока ТОЛУ-10-1

Купить

Под заказ

Трансформатор ТИОГ-100

Купить

Под заказ

Трансформаторы НОГ

Купить

Под заказ

Трансформаторы ТОС

Купить

Под заказ

Трансформаторы тока ТОЛК6

Купить

Под заказ

Трансформатор тока ТТ-350

Купить

Под заказ

Трансформатор тока ТШ-0,66А

Купить

Трансформеры в НЛП: объяснение для начинающих

Или, как мне нравится называть это, «Внимание к стероидам».

💉💊 Фото Арсения Тогулева на Unsplash

💉💊 Фото Арсения Тогулева на UnsplashНет, эта статья не об американском научно-фантастическом сериале боевиков — здесь нет Оптимуса Прайма. Речь также не идет об электрическом устройстве, которое используется для передачи энергии от одной электрической цепи к другой. О чем же тогда, спросите вы?

Речь идет об одной из самых научно-фантастических областей всех времен, в частности, об искусственном интеллекте — обработке естественного языка, и она довольно оптимальна для передачи информации и используется в первую очередь. (Посмотрите, что я там сделал. :P)

Этот пост основан на статье: Внимание — это все, что вам нужно. P.S. авторы не шутили, когда выбрали это название, потому что для этого вам потребуется все внимание, которое у вас есть. Но пусть это вас не пугает, оно того стоит!!

Преобразователь в НЛП — это новая архитектура , которая направлена на решение последовательных задач, с легкостью обрабатывая долговременные зависимости. Он полностью полагается на собственное внимание, чтобы вычислить представления своих входных и выходных данных 9.0013 БЕЗ с использованием выровненных по последовательности RNN или свертки. 🤯

Он полностью полагается на собственное внимание, чтобы вычислить представления своих входных и выходных данных 9.0013 БЕЗ с использованием выровненных по последовательности RNN или свертки. 🤯

Если вы помните мой предыдущий пост «Понимание внимания в глубоком обучении», мы обсуждали, как и почему многие модели не справляются с долговременными зависимостями. Концепция внимания в некоторой степени позволила нам преодолеть эту проблему, и теперь в «Трансформерах» мы будем опираться на внимание и полностью раскрыть его потенциал.

Понимание внимания в глубоком обучении

Как мало внимания изменило игру ИИ!

в направлении datascience.com

Само-внимание

Давайте начнем с повторного рассмотрения того, что такое внимание во вселенной НЛП? Понимание внимания в глубоком обучении. ( Я извиняюсь за эту вопиющую саморекламу, но серьезно прочитайте ее. Это поможет вам в Трансформерах намного лучше. Обещаю. )

Внимание позволило нам сосредоточиться на частях нашей входной последовательности, пока мы предсказывали наша выходная последовательность . Если бы наша модель предсказывала слово « rouge »[французский перевод слова «красный цвет»], мы, скорее всего, обнаружим в нашей входной последовательности большое значение веса для слова « red ». Таким образом, внимание позволило нам отобразить некоторую связь/корреляцию между входным словом « rouge » и выходным словом « red ».

Если бы наша модель предсказывала слово « rouge »[французский перевод слова «красный цвет»], мы, скорее всего, обнаружим в нашей входной последовательности большое значение веса для слова « red ». Таким образом, внимание позволило нам отобразить некоторую связь/корреляцию между входным словом « rouge » и выходным словом « red ».

Внимание к самому себе , иногда называемое внутренним вниманием, представляет собой механизм внимания, связывающий различные положения одной последовательности для вычисления представления этой последовательности.

Проще говоря, внимание к себе помогает нам создавать подобные связи, но в рамках одного предложения. Посмотрите на следующий пример:

«Я налил воду из бутылки в чашку , пока она не стала полной ».

it => cup«Я налил воду из бутылки в чашку, пока она не стала пустой .»

это=> бутылка

Путем изменения одного слова « полный » -> « пустой » объект ссылки для « это » изменился. Если мы переводим такое предложение, нам нужно знать, к чему относится слово « это ».

В модели возможны три вида внимания:

- Внимание кодера-декодера : Внимание между входной последовательностью и выходной последовательностью.

- Самостоятельное внимание во входной последовательности : Обслуживает все слова во входной последовательности.

- Внимание к себе в выходной последовательности: Здесь следует опасаться того, что объем внимания к себе ограничен словами, которые встречаются перед данным словом. Это предотвращает любые утечки информации во время обучения модели. Это делается путем маскирования слов, которые встречаются после него для каждого шага. Таким образом, на шаге 1 НЕ маскируется только первое слово выходной последовательности, на шаге 2 первые два слова НЕ маскируются и так далее.

Ключи, значения и запросы:

Три случайных слова, которые я только что бросил вам в этом заголовке, являются векторами, созданными как абстракции, полезные для вычисления собственного внимания, более подробная информация о каждом из них приведена ниже. Они рассчитываются путем умножения вашего входного вектора ( X ) на весовые матрицы, полученные во время обучения.

- Вектор запроса : q = X * Wq. Думайте об этом как о текущем слове.

- Ключевой вектор : k = X * нед. Воспринимайте это как механизм индексации вектора значений. Подобно тому, как у нас есть пары ключ-значение в хэш-картах, где ключи используются для уникального индексирования значений.

- Вектор значений: v = X * Wv. Думайте об этом как об информации во входном слове.

Мы хотим взять запрос q и найти наиболее похожий ключ k , произведя скалярное произведение для q и k . Ближайший продукт ключа запроса будет иметь наибольшее значение, за ним следует softmax, который будет управлять q.k с меньшими значениями, близкими к 0, и q.k с большими значениями, близкими к 1. Это распределение softmax умножается на и . векторы значений, умноженные на ~1, привлекут больше внимания, а те, умноженные на ~0, получат меньше. Размеры этих векторов q, k и v обозначаются как « скрытый размер 9».0032 » различными реализациями.

Ближайший продукт ключа запроса будет иметь наибольшее значение, за ним следует softmax, который будет управлять q.k с меньшими значениями, близкими к 0, и q.k с большими значениями, близкими к 1. Это распределение softmax умножается на и . векторы значений, умноженные на ~1, привлекут больше внимания, а те, умноженные на ~0, получат меньше. Размеры этих векторов q, k и v обозначаются как « скрытый размер 9».0032 » различными реализациями.

Все эти матрицы Wq, Wk и Wv изучаются при совместном обучении во время обучения модели.

Вычисление внимания к себе по q, k и v:

Формула внимания к себе. Источник: бумага.Если мы вычисляем собственное внимание для #i входного слова,

- Шаг 1: Умножьте qᵢ на ключевой вектор слова kⱼ.

- Шаг 2: Затем разделите это произведение на квадратный корень из размерности ключевого вектора.

Этот шаг выполняется для улучшения потока градиента , что особенно важно в случаях, когда значение скалярного произведения на предыдущем шаге слишком велико. Поскольку их прямое использование может подтолкнуть softmax к областям с очень небольшим потоком градиента. - Шаг 3: Когда у нас есть оценки для всех j s, мы пропускаем их через softmax. Мы получаем нормализованное значение для каждого и .

- Шаг 4: Умножьте баллы softmax для каждого j на вектор v ᵢ .

Идея/цель здесь, очень похожее внимание, чтобы сохранить только значения v входных слов, на которых мы хотим сосредоточиться, умножая их на оценки с высокой вероятностью из softmax ~1, и удаляя остальные на приближая их к 0, то есть делая их очень маленькими, умножая их на оценки низкой вероятности ~ 0 из softmax.

Если вы ищете аналогию между вниманием к себе и вниманием, подумайте о том, что z служит целям векторов контекста, а не глобальных весов выравнивания.

Если вы ищете аналогию между вниманием к себе и вниманием, подумайте о том, что z служит целям векторов контекста, а не глобальных весов выравнивания.⚠️ Предостережение : содержимое этого изображения может показаться экспоненциально более сложным, чем оно есть на самом деле. Мы разобьем этого страшного зверя на маленьких зверюшек, и все это обретет смысл. (Обещаю #2)

(слева) Архитектура Transformer. Источник: бумага. (справа) Абстрактная версия того же для лучшего понимания.Beast #1: Стеки кодировщика-декодера

Кодировщик : Кодер отображает входную последовательность представлений символов (x ₁ , …, x ₙ ) представление последовательности ( s) z ₁ , …, z ₙ ) . Думайте о них как о результатах самоконтроля с некоторой постобработкой.

Каждый кодировщик имеет два подуровня.

- Многоголовочный механизм самоконтроля на входных векторах (представьте себе распараллеленный и эффективный аналог самоконтроля).

- Простая позиционно-ориентированная полностью подключенная сеть прямой связи (подумайте о постобработке).

Взгляните на эту абсолютную трехмерную диаграмму блока кодировщика, используемого в BERT. Серьезно, вы не можете это пропустить!!! Это как совершенно новый уровень понимания.

Декодер : Учитывая z , декодер генерирует выходную последовательность (y ₁ , …, y ₘ ) символов за один раз.

Каждый декодер имеет три подуровня.

- A маскированный многоголовочный механизм самоконтроля на выходных векторах предыдущей итерации.

- Механизм многоголового внимания на выходе кодера и маскированное многоголовое внимание в декодере.

- Простая позиционно-ориентированная полностью подключенная сеть прямой связи (подумайте о постобработке).

Несколько дополнительных точек:

- В исходной статье в стеке кодировщика присутствовало 6 уровней (версия с 2 подуровнями) и 6 в стеке декодера (версия с 3 подуровнями).

- Все подслои в модели, а также встраивающие слои производят выходные данные одинакового размера. Это делается для облегчения остаточных соединений.

Зверь № 2 Внутри стеков кодировщика-декодера — Multi-Head Attention:

Три вида внимания в стеках кодировщика и декодера вместе с нейронными сетями прямой связи. Мы только что отметили, что выходные данные каждого подуровня должны иметь ту же размерность, что и 512 в нашей статье.

=> zᵢ должен иметь размерность 512.

=> vᵢ должно иметь размерность 512, поскольку zᵢ — это просто взвешенные суммы vᵢs.

Кроме того, мы хотим, чтобы модель фокусировалась на разных позициях, путем расчета внимания к самому себе несколько раз с различными наборами из векторов q, k и v , а затем взять среднее значение всех этих выходных данных, чтобы получить нашу финал г .

Таким образом, вместо того, чтобы иметь дело с этими огромными векторами и усреднять несколько выходных данных, мы уменьшаем размер наших векторов k,q и v до некоторого меньшего размера — уменьшаем размер матриц Wq, Wk и Wv также. Мы сохраняем множественные наборы ( h ) из k, q и v, а обозначают каждый набор как « внимание головы», отсюда и название многоголовое внимание. И, наконец, вместо усреднения, чтобы получить финальные z , мы объединяем их.

Размер объединенного вектора будет слишком велик для передачи на следующий подуровень, поэтому мы уменьшаем его, умножая на другую изученную матрицу Wo .

(слева) Масштабированное скалярное произведение Внимание. (справа) Multi-Head Attention состоит из нескольких слоев внимания, работающих параллельно. Источник: бумага. Множественные головки внимания позволили модели совместно обращать внимание на информацию из разных подпространств представления в разных позициях, что было запрещено усреднением в одной головке внимания.

Зверь #3 — Предварительная обработка ввода и вывода:

Входные слова представлены с использованием некоторой формы встраивания. Это делается как для кодировщика, так и для декодера.

Встраивание слов само по себе не имеет какой-либо позиционной информации, которая достигается в RNN в силу их последовательного характера. Между тем, при самоконтроле из-за softmax любая такая позиционная информация теряется.

Чтобы сохранить позиционную информацию, преобразователь вводит вектор в отдельные входные вложения (может быть использовано встраивание слов для соответствия входным словам). Эти векторы следуют определенной периодической функции (пример: комбинация различных синусов/косинусов, имеющих разную частоту, короче говоря, не синхронизированных друг с другом), которую модель изучает и способна определить положение отдельных слов относительно друг друга на основе значений .

Этот введенный вектор называется « позиционное кодирование » и добавляется к входным вложениям в нижней части стеков кодировщика и декодера.

Зверь #4 — стек декодера: пересмотрено

Выходные данные стека декодера на каждом шаге возвращаются в декодер на следующем временном шаге — очень похоже на то, как выходные данные предыдущих шагов в RNN использовались в качестве следующих скрытых состояний. И так же, как мы делали с входными данными кодировщика, мы внедряем и добавляем позиционное кодирование к этим входным данным декодера, чтобы сохранить положение каждого слова. Эта комбинация позиционного кодирования + встраивания слов затем подается в замаскированное многоголовое внимание к себе.

Этот подуровень самоконтроля в стеке декодера изменен, чтобы предотвратить обращение позиций к последующим позициям — вы не можете смотреть на будущие слова. Эта маскировка гарантирует, что прогнозы для позиции i могут зависеть только от известных выходных данных в позициях меньше, чем i .

Выходные данные из стека кодировщика затем используются как несколько наборов векторов ключей k и векторов значений v для слоя «внимание декодера кодировщика» — показано зеленым на диаграмме. Это помогает декодеру сосредоточиться на контекстуально значимых частях входной последовательности для этого шага. (Часть, похожая на глобальные векторы внимания.) q вектор исходит из слоя «вывод собственного внимания».

Это помогает декодеру сосредоточиться на контекстуально значимых частях входной последовательности для этого шага. (Часть, похожая на глобальные векторы внимания.) q вектор исходит из слоя «вывод собственного внимания».

Получив вывод декодера, мы снова делаем softmax, чтобы выбрать окончательные вероятности слов.

Давайте закончим кратким обзором.

- Мы начали с понимания того, что такое внимание к себе и как рассчитать внимание к себе из этих векторов v, k ,q .

- Многоцелевое внимание — это эффективная модификация внимания к себе, которая использует несколько меньших наборов из v, k ,q и объединяет выходные данные каждого набора, чтобы получить окончательный z.

- Затем мы увидели, как и где в модели используются три вида внимания к себе.

- Затем выполняется предварительная обработка входных данных для стеков кодировщика и декодера.

Я рад, что вы дочитали до конца этой статьи.

🎉

Надеюсь, ваш читательский опыт был таким же полезным, как и мой, когда я писал это. 💖Если вам понравилась эта статья, посмотрите другие мои здесь.

Если вы хотите связаться со мной, я выбираю Twitter.

Подробное руководство по трансформерам — neptune.ai

У вас есть лист бумаги с текстом, и вы хотите построить модель, которая сможет перевести этот текст на другой язык. Как вы относитесь к этому?

Первая проблема — переменный размер текста. Не существует модели линейной алгебры, которая могла бы работать с векторами различной размерности.

По умолчанию для решения таких проблем используется модель мешка слов (1). В этой модели данные будут вектором массивного числа, такого же большого, как количество слов в языке, и большинство элементов вектора будут нулевыми, так как большинство терминов не используются в этом тексте. Чтобы минимизировать размер вектора для вычислений, мы сохраняем только позиции представленных слов.

Однако модель «мешок слов» игнорирует порядок слов, что очень важно. Например: « Работай, чтобы жить » отличается от « Живи, чтобы работать ». Чтобы сохранить порядок данных, мы увеличим размерность графика ( n-gram ), чтобы добавить порядок в наше уравнение.

В n-граммовых моделях вероятность слова зависит от ( n-1 ) предыдущих комментариев, а это означает, что модель не будет коррелировать со словами ранее, чем ( n-1 ). Чтобы преодолеть это, нам придется увеличить n, что экспоненциально увеличит сложность вычислений (2).

Итак, вот какие проблемы у нас есть:

- Переменная длина текста.

- Огромный размер данных после применения модели мешка слов.

- Стоимость вычислений при увеличении размерности.

Рекуррентные нейронные сети (RNN)

RNN аналогична модели n-грамм, за исключением того, что результат текущего ввода будет зависеть от результата всех предыдущих вычислений. RNN имеет свое внутреннее состояние, которое работает как память. Он очень подходит для обработки естественного языка и распознавания речи.

RNN имеет свое внутреннее состояние, которое работает как память. Он очень подходит для обработки естественного языка и распознавания речи.

На этой диаграмме показано, что ввод за раз (t+6) зависит от скрытого состояния каждого предыдущего шага и текущего ввода. Это позволяет сети хранить историю ранее изученных параметров и использовать ее для прогнозирования следующего вывода, что решает проблему порядка слов и устраняет затраты на вычисления, поскольку мы просто будем передавать слова по отдельности в нашей модели.

Эта модель кажется идеальной, но на практике у нее есть некоторые проблемы (5):

- Проблема исчезающих или взрывающихся градиентов.

- Мы не можем распараллелить вычисления, так как результат зависит от предыдущих вычислений.

Итак, модель RNN не идеальна. Таким образом, он был изменен, чтобы преодолеть эти недостатки.

Узнать больше

Руководство по рекуррентной нейронной сети — глубокое погружение в RNN

Долгая кратковременная память (LSTM)

Этот конкретный тип RNN добавляет механизм забывания, поскольку модуль LSTM разделен на ячейки. Каждая ячейка принимает три входа: :

Каждая ячейка принимает три входа: :

- текущий вход,

- скрытое состояние,

- состояние памяти предыдущего шага (6).

Эти входы проходят через ворота:

- входные ворота,

- ворота забыть, Выходной вентиль

- .

Шлюзы регулируют передачу данных в ячейку и из нее.

Ворота забывания решают, когда запоминать, а когда пропускать входные данные из предыдущих скрытых состояний. Этот дизайн был в основном создан для решения проблем исчезающих и взрывающихся градиентов.

Вычисление скрытых состояний в LSTM [источник]LSTM удалось преодолеть исчезающие и взрывающиеся градиенты в модели RNN, но все еще есть проблемы, унаследованные от модели RNN, например:

- Нет распараллеливания, у нас все еще есть последовательный путь для данных, еще более сложный, чем раньше.

- Аппаратные ресурсы по-прежнему являются проблемой.

Решений недостаточно для решения проблемы памяти и параллелизма. Итак, пришло время представить еще одну модель.

Итак, пришло время представить еще одну модель.

Трансформаторы

В предыдущих разделах мы представили проблемы, с которыми мы сталкиваемся, и некоторые из предложенных решений, которые исправили часть проблем. Но место для исследований еще есть.

Мы упомянули проблему переменной длины при переводе последовательности в последовательность, которая еще не была решена.

Чтобы решить эту проблему, в 2017 году была представлена модель, которая зависит от механизмов внимания. Вместо того, чтобы обрабатывать токены отдельно, мы разбиваем текст на сегменты и изучаем зависимости между ними.

Эта модель была разработана на основе другой архитектуры, состоящей из двух основных компонентов.

Ввод сначала проходит через энкодер.

Этот кодировщик примет ввод переменной длины и преобразует его в скрытое состояние с фиксированной длиной.

Затем скрытое состояние будет проходить через второй компонент, который представляет собой декодер, преобразующий состояние фиксированной длины в выходные данные переменной длины.

Эта архитектура называется архитектурой кодер-декодер (4).

Архитектура кодера-декодера [источник] Обучение последовательности за последовательностью [источник]В Transformers входные токены преобразуются в векторы, а затем мы добавляем некоторую позиционную информацию (позиционное кодирование), чтобы принять порядок следования токенов в счет во время параллельной обработки модели.

Преобразователи модифицировали эту модель, чтобы сделать ее устойчивой к предыдущим проблемам, которые мы обсуждали, используя многослойное внутреннее внимание и полносвязные уровни как для кодировщика, так и для декодера.

См. также

10 вещей, которые вам нужно знать о BERT и архитектуре Transformer, которые меняют ландшафт ИИ

Кодер:

Декодер: состоит из множества слоев, по три подуровня в каждом; первые два уровня аналогичны слоям кодировщика, а третий представляет собой многоголовое внимание к выходным данным стека кодировщика.

Архитектура трансформатора [источник]Механизмы внимания

Эта модель была вдохновлена системой человеческого зрения (7). Поскольку мозг получает огромное количество информации от глаз, больше, чем мозг может обработать за раз, сигналы внимания в сенсорной системе глаз делают людей способными обращать внимание на часть того, что получают глаза.

Мы можем применить эту методологию к рассматриваемой проблеме. Если мы знаем части, которые могут повлиять на наш перевод, мы можем сосредоточиться на этих частях и игнорировать другую бесполезную информацию.

Это повлияет на производительность системы. Пока вы читаете эту статью, вы обращаете внимание на эту статью и игнорируете остальной мир. Это связано с затратами, которые можно описать как альтернативные издержки.

Мы можем выбирать из различных типов механизмов внимания, таких как объединение внимания и полносвязные слои.

При объединении внимания входы в систему внимания можно разделить на три типа:

- Ключи (непроизвольные сигналы),

- запросов (волевые сигналы),

- Значения (сенсорные входы).

Мы можем визуализировать веса внимания между Ключами и Запросами. Значения и ключи — это скрытые состояния кодировщика, а запрос — результат предыдущего декодера.

Визуализация матрицы веса внимания (источник)Масштабированное скалярное произведение Внимание

Масштабированное скалярное произведение представляет собой более эффективную схему вычислений для функции подсчета очков.

Мы вычисляем скалярное произведение входных запросов (Q) и ключей (K) с одинаковой длиной вектора (d). Затем мы масштабируем их, чтобы убедиться, что дисперсия сохраняется при разных длинах векторов, а затем применяем функцию softmax, чтобы получить веса значений (V).

Масштабированное внимание с точечным произведением и внимание с несколькими головками [источник]

Внимание с несколькими головками

Мы выполняем одно внимание с точечным произведением ч раз параллельно.

W — веса ключей, запросов и значений, а O — выходное линейное преобразование.

Внимание Multi-head используется в нашей модели в:

- Слои декодера; Запросы — это выходные данные предыдущего уровня декодера, а Ключи — это выходные данные кодировщика.

- Слои самоконтроля энкодера; ключи, запросы и значения взяты из предыдущего уровня кодировщика.

Самостоятельное внимание

Особый механизм внимания, в котором запросы, ключи и значения берутся из одного источника. Самостоятельное внимание (внутреннее внимание) работает быстрее, чем рекуррентные уровни, когда длина последовательности (n) меньше размерности представления (d).

Самостоятельное внимание используется для изучения корреляции разных слов в одном предложении, чтобы вычислить представление одного и того же предложения.

Позиционная сеть прямой связи

Каждый уровень кодировщика и декодера содержит полностью связанную сеть прямой связи, которая преобразует представление в каждой позиции с идентичной сетью прямой связи двух линейных преобразований и активации ReLU функция.

Вложения и softmax

Преобразование входных и выходных токенов в векторы размерности модели и преобразование выходных данных декодера в предсказанные вероятности.

См. также

Обучение, визуализация и понимание встраивания слов: глубокое погружение в пользовательские наборы данных

Позиционное кодирование

Поскольку модель не имеет повторения и свертки, был добавлен слой для использования порядка последовательности. В конце стеков кодировщика и декодера введенная информация содержит информацию об относительном или абсолютном положении токена в этой последовательности.

Обзор Vanilla Transformer

Vanilla Transformer — отличная модель для преодоления недостатков моделей RNN, но у нее все еще есть две проблемы:

- Ограниченная зависимость от контекста: для моделирования языка на уровне символов модель оказалась превзойти LSTM.

Однако, поскольку модель была разработана для обучения на отдельных сегментах фиксированной длины в несколько сотен символов без информации для корреляции между сегментами, это создало проблему, заключающуюся в том, что информация о долгосрочных зависимостях не хранится за пределами настроенной длины контекста. Ограниченная зависимость от контекста также делает моду несовместимой ни с одним словом, появившимся несколько сегментов назад.

Однако, поскольку модель была разработана для обучения на отдельных сегментах фиксированной длины в несколько сотен символов без информации для корреляции между сегментами, это создало проблему, заключающуюся в том, что информация о долгосрочных зависимостях не хранится за пределами настроенной длины контекста. Ограниченная зависимость от контекста также делает моду несовместимой ни с одним словом, появившимся несколько сегментов назад. - Фрагментация контекста: в первых нескольких символах каждого сегмента контекстная информация не сохраняется, поскольку модель обучается с нуля для каждого сегмента, что приводит к проблемам с производительностью.

Итак, нам все еще нужно еще одно усовершенствование для решения этих проблем и преодоления этих недостатков.

Vanilla Transformer с сегментом 4 [источник]Transformer-XL

Transformer XL — более новая версия Transformer (он очень длинный). Он получен из ванильного Трансформера, но вводит механизм повторения и относительное позиционное кодирование.

В Transformer-XL вместо вычисления скрытого состояния с нуля для каждого сегмента модель будет сохранять скрытое состояние ранее изученных сегментов и использовать его для текущего сегмента.

Модель решает проблемы, появившиеся в модели ванильного трансформатора, и преодолевает проблему долгосрочной зависимости. Другое преимущество заключается в том, что он также решает проблему фрагментации контекста, вызванную использованием недавно инициализированной или пустой контекстной информации. Следовательно, новую модель теперь можно использовать для моделирования языка на уровне символов и моделирования на уровне слов.

Механизм повторения

Чтобы сохранить зависимости между сегментами, Transformer-XL представил этот механизм. Transformer-XL обработает первый сегмент так же, как обычный трансформатор, а затем сохранит выходные данные скрытого слоя при обработке следующего сегмента.

Повторение также может ускорить оценку. Мы можем использовать предыдущие представления сегментов вместо того, чтобы вычислять их с нуля на этапе оценки.

Итак, ввод для каждого слоя будет конкатенированной формой следующего:

- Выход предыдущего слоя, такой же, как и в ванильном Трансформере (серые стрелки на следующем рисунке).

- Вывод ранее обработанного скрытого слоя (зеленые стрелки на следующем рисунке) в виде расширенного контекста.

Относительное позиционное кодирование

Механизм повторения, кажется, решает все наши проблемы. Тем не менее, механизм повторения привнес еще одну проблему: позиционная информация, хранящаяся в скрытом состоянии, повторно использовалась из предыдущего сегмента.

Как и в случае с ванильным преобразователем, позиционная информация, предоставленная на этапе позиционного кодирования, может привести к тому, что некоторые токены из разных сегментов будут иметь одинаковое позиционное кодирование, хотя они различаются по своему положению и важности.

Фундаментальная концепция, добавленная в эту модель, заключается только в том, чтобы кодировать информацию об относительном положении в скрытом состоянии, достаточном, чтобы знать позиционное смещение между каждым ключом и его запросом, и достаточном, чтобы делать прогнозы.

Резюме Transformer XL

Transformer-XL объединил повторение с механизмами внимания, преобразовав ванильную модель преобразователя, которая страдала от фрагментации контекста и ограниченной зависимости от контекста, в языковое моделирование на уровне слов, а также повысил скорость его оценки за счет добавления механизма повторения. и кодирование относительного положения.

Это приводит к расширению долгосрочной зависимости. Согласно оригинальной статье Transformer-XL, он может изучать зависимость на 80% дольше, чем RNN, и на 450% дольше, чем ванильные преобразователи, и обеспечивает лучшую производительность на длинных и коротких последовательностях до 1800+ раз быстрее, чем ванильный преобразователь.

Эта модель была реализована в TensorFlow и PyTorch и доступна с открытым исходным кодом.

Compressive Transformer

Одним из недостатков сохранения всех этих скрытых состояний является то, что это увеличивает вычислительные затраты на каждый временной шаг и затраты на хранение всей этой информации.

Было создано несколько методов для снижения вычислительных затрат на внимание, таких как механизмы разреженного доступа, но это не решает проблему затрат на хранение.

Компрессионный трансформатор представляет собой простое расширение трансформатора, вдохновленное концепцией сна. Известно, что сон сжимает память, что улучшает способность рассуждать.

Сжимающий преобразователь использует внимание для выбора информации из прошлого, а затем сжимает ее в сжатую память. Это сжатие выполняется с помощью нейронной сети, обученной функции потерь для сохранения актуальной информации.

Трансформатор сжатия [источник]Функции сжатия

Создан на базе Transformer-XL. XL сохраняет прошлые активации для каждого слоя и отбрасывает их только тогда, когда они устаревают. Модель сжатия была реализована для сжатия старых воспоминаний вместо их отбрасывания.

В этой модели используются различные функции сжатия:

- Максимальное/среднее объединение.

- Идентификационная свертка.

- Расширенная свертка.

- Наиболее часто используемые.

Объединение в пул считается самым быстрым и простым. Наиболее часто используемая функция сжатия вдохновлена механизмом сборки мусора в дифференциальных нейронных компьютерах, и данные сохраняются в соответствии с ее средним использованием. Функция сверточной компрессии имеет некоторые веса для обучения.

Краткий обзор преобразователя сжатия

Преобразование сжатия полезно при моделировании на больших расстояниях. Если это не относится к вашему проекту, то компрессионное преобразование не добавит никаких преимуществ.

Как видно из следующего сравнения, результаты очень близки к Transformer-XL, но с огромным преимуществом оптимизации использования памяти.

Результаты сравнения с исходной статьей [источник]Реформер

Заменяет внимание скалярного произведения хешированием с учетом местоположения, что изменило сложность модели с O(L2) на O(Llog L) и использовало обратимая версия остаточных слоев вместо использования стандартного остаточного слоя.

1.1

1.1 »

»

🎉

🎉  Однако, поскольку модель была разработана для обучения на отдельных сегментах фиксированной длины в несколько сотен символов без информации для корреляции между сегментами, это создало проблему, заключающуюся в том, что информация о долгосрочных зависимостях не хранится за пределами настроенной длины контекста. Ограниченная зависимость от контекста также делает моду несовместимой ни с одним словом, появившимся несколько сегментов назад.

Однако, поскольку модель была разработана для обучения на отдельных сегментах фиксированной длины в несколько сотен символов без информации для корреляции между сегментами, это создало проблему, заключающуюся в том, что информация о долгосрочных зависимостях не хранится за пределами настроенной длины контекста. Ограниченная зависимость от контекста также делает моду несовместимой ни с одним словом, появившимся несколько сегментов назад.