Тзрл трансформатор: ТЗРЛ трансформаторы тока нулевой последовательности. Описание. Цена. Заказ.

alexxlab | 30.05.2023 | 0 | Разное

Трансформаторы тока ТЗРЛ, ТЗРЛ-70, ТЗРЛ 100, ТЗРЛ-125, ТЗРЛ-200

Назначение трансформатора ТЗРЛ-70, ТЗРЛ 100, ТЗРЛ-125, ТЗРЛ-200.

ОТГРУЗКА ПРОДУКЦИИ ТРАНСФОРМАТОРЫ ТЗРЛ В ЛЮБОЙ РЕГИОН РОССИИ, ДОСТАВКА ДО ТРАНСПОРТНОЙ КОМПАНИИ БЕСПЛАТНО.

Заказать продукцию трансформаторы, узнать о наличии, сроках поставки Вы можете позвонив по телефонам или написать заявку по электронной почте:

моб. 8(916) 579-74-12

т.ф.(499)948-03-51

(495) 545-70-88

E-mail: [email protected]

Трансформатор тока нулевой последовательности ТЗРЛ-70, ТЗРЛ 100, ТЗРЛ-125, ТЗРЛ-200.

предназначен для питания схем релейной защиты от замыкания на землю отдельных жил трехфазного кабеля путем трансформации возникших при этом токов нулевой последовательности.

Трансформатор тока ТЗРЛ изготавливается в исполнении “У” категории 3 по ГОСТ 15150 и предназначен для работы в следующих условиях:

– высота над уровнем моря не более 1000 м;

– температура окружающей среды при эксплуатации – от минус 45°С до плюс 50°С, при транспортировании – от минус 50°С до плюс 60°С;

– окружающая среда не взрывоопасная, не содержащая пыли, химически активных газов и паров в концентрациях, разрушающих покрытия металлов и изоляцию;

– рабочее положение – любое.

Технические данные.

Наименование параметра | Норма |

| Номинальная частота, Гц | 50 или 60 |

| Номинальное напряжение, кВ | 0,66 |

| Односекундный ток термической стойкости вторичной обмотки, А | 140 |

| Испытательное одноминутное напряжение промышленной частоты, кВ | 3 |

Таблица 2. Максимальная чувствительность защиты.

Максимальная чувствительность защиты.

Тип реле | Уставка тока | Чувствительность защиты (первичный ток, А), не более | |||

при работе с | при после- | при параллель- | |||

| РТ-140/0,2 РТЗ-51 | 0,1–0,2 | 0,1 | 25 | 30 | 45 |

Разъемный трансформатор тока ТЗРЛ для защиты.

Таблица 1. Технические характеристики трансформатора.

Наименование параметра | Значение | ||

Номинальное напряжение, кВ | 0,66 | ||

Наибольшее рабочее напряжение, кВ | 0,8 | ||

Номинальная частота, Гц | 50 или 60* | ||

Номинальный первичный ток, А | 50-2000 | ||

Наибольший рабочий первичный ток, А | 50-2000 | ||

Номинальный вторичный ток, А | 1 | ||

Количество вторичных обмоток, шт. | 1 | ||

Номинальная вторичная нагрузка, при cos φ = 0,8 (нагрузка индуктивно – активная) | 3 – 30** | ||

Класс точности по ГОСТ 7746 | 10Р | ||

Односекундный ток термической стойкости, А, не менее | 80 | ||

Номинальная предельная кратность вторичной обмотки, не менее | Уточняется при заказе | ||

Примечание *Только для трансформаторов, предназначенных для поставок на экспорт.

**Уточняется при заказе

Разъемный трансформатор тока нулевой последовательности ТЗРЛ для микропроцессорной защиты

Назначение.

Трансформаторы ТЗРЛ для микропроцессорной защиты предназначены для схем релейной защиты от замыкания на землю путем трансформации возникших при этом токов нулевой последовательности и устанавливаются на кабель.

Трансформаторы ТЗРЛ выпускаются исполнения У2 и Т2.

У или Т – климатическое исполнение по ГОСТ 15150;

2 – категория размещения по ГОСТ 15150.

Таблица 1. Технические характеристики трансформаторов ТЗРЛ для микропроцессорной защиты.

Наименование параметра | Значение |

Номинальное напряжение, кВ | 0,66 |

Номинальная частота, Гц | 50,60* |

Односекундный ток термической стойкости вторичной обмотки, А | 20,0 |

Чувствительность защиты по первичному току при работе с реле РТЗ-51 с током уставки 0,03 А и сопротивлении соединительных проводов 1 Ом, не более, А: | 25 |

Номинальный первичный ток, А, не более | 100 |

Трансформаторы ТЗРЛ для микропроцессорной защиты используются для эксплуатации с микропроцессорной защитой типа SEPAM или микропроцессорной защитой другого типа по согласованию с заказчиком.

Работа с региональными заказчиками по продукции ТЗРЛ, доставка до транспортной компании бесплатно. Вы оплачиваете выставленный счет, письмом указываете, до какого города и терминала отправить Вам продукцию трансформаторы ТЗРЛ, нужна ли дополнительная упаковка. Основная отгрузка продукции трансформаторов ТЗРЛ, производится транспортной компанией «деловые линии», если заинтересованы что бы отгрузка была совершена другой транспортной компанией , указываете это в письме и мы с вами согласуем условия отгрузки в ваш город.

На условиях самовывоза продукции ТЗРЛ, с нашего склада, обязательно не забудьте доверенность или печать. Отгрузка трансформаторов производится с понедельника по пятницу включительно с 10.00-16.00. московское время.

Если вы заинтересованы что бы трансформаторы тзрл были доставлены за наш счет до терминала вашего города или адресата, укажите это в предварительной заявке и менеджер выставит счет и включит в стоимость продукции доставку трансформаторов.

При отгрузки трансформатора транспортной компанией необходимо указать нужна ли дополнительная упаковка.

Электрооборудование промышленное.

Трансформатор тока нулевой последовательности.ТЗРЛ70, ТЗРЛ100, ТЗРЛ125, ТЗРЛ200. Изготовим разного диаметра. Разборный трансформатор, ТЗРЛ 70, 100,125,200, Изготавливается с разными коэффицентом трансформации. В наличии и под заказ. ТЗРЛ-70,ТЗРЛ-100,ТЗРЛ-125,ТЗРЛ-200. звоните89165797412.Доставка до транспортной компании бесплатно.

Время последней модификации 1660724779

Трансформаторы ТЗРЛ – расшифровка, содержание драгметаллов, характеристики, справочник, схема, габариты, чертеж

Разъемные трансформаторы ТЗРЛ используются для работы в схемах релейной защиты от замыкания на землю посредством трансформации возникших при этом токов нулевой последовательности и размещаются на кабеле. Трансформатор монтируется на кабель диаметром от 70, 100, 125, 150, 180 и 200 мм.

Изоляция между токоведущими жилами кабеля и обмотками трансформатора надежно обеспечивается залитым компаундом и изоляцией кабеля, что гарантирует использование трансформаторов в распределительных устройствах до 10 кВ.

Трансформатор выполнен в виде опорной разъемной конструкции. Роль первичной обмотки выполняет трехфазный кабель на напряжение до 10 кВ, пропущенный в окно трансформатора. Вторичная обмотка намотана на тороидальный магнитопровод, разрезанный пополам. Обе части, залитые изоляционным компаундом на основе эпоксидной смолы, соединяются болтами. Опорой трансформатора служит основание изоляционного корпуса со специальными втулками для крепления.

Особенности трансформаторов ТЗРЛ

- Трансформаторы ТЗРЛ устанавливаются на кабели диаметром 70, 100, 125, 150 или 200 мм.

- Рабочее положение — любое.

- Выпускаются в виде опорной разъемной конструкции.

- Роль первичной обмотки выполняет кабель, пропущенный в окно трансформаторов.

- Главная изоляция между токопроводящими жилами кабеля и вторичной обмоткой трансформаторов обеспечивается изоляцией кабеля.

- Вторичная обмотка намотана на разрезной магнитопровод и залита эпоксидным компаундом, что обеспечивает электрическую изоляцию и защиту обмотки от проникновения влаги и механических повреждений.

- Разрезные части трансформаторов соединяются при помощи шпилек.

- Допускается использование измерительных трансформаторов ТЗРЛ в электрических цепях на номинальное напряжения выше 0,66 кВ, при условии, что главная изоляция между токопроводящими жилами кабеля и вторичной обмоткой трансформаторов обеспечивается собственной изоляцией кабеля.

Расшифровка ТЗРЛ

ТЗРЛ-150-10Р-600/1-30- У3:

Т — трансформатор тока;

З — для защиты от замыканий на землю;

Р — разъемный;

Л — с литой изоляцией;

150 — диаметр кабеля, пропущенного в окно трансформатора;

10Р — класс точности;

600/1 — Коэффициент трансформации;

30 — Мощность, ВА;

У3 — климатическое исполнение и категория размещения по ГОСТ 15150-69, ГОСТ 15543.1-89.

Технические характеристики ТЗРЛ

| Номинальное напряжение, кВ | 0,66 | |||

| Номинальная частота, Гц | 50 или 60 | |||

| Номинальный первичный ток, А* | 600; 750; 800; 1000; 1200; 1500; 2000 | |||

| Наибольший рабочий первичный ток, А | 630; 800; 800; 1000; 1250; 1600; 2000 | |||

| Номинальный вторичный ток, А | 1 | |||

Количество вторичных обмоток, шт. | 1 | |||

| Номинальная вторичная нагрузка, ВА при cos φ = 0,8 (индуктивно активная) | 3; 5; 10; 15; 20; 25; 30 | |||

| Класс точности по ГОСТ 7746 | 5Р; 10Р | |||

| Односекундный ток термической стойкости, А, не менее | 80 | |||

| Номинальная предельная кратность вторичной обмотки*, не менее, при номинальном первичном токе, А: | ТЗРЛ-70 | ТЗРЛ-100; | ТЗРЛ-150 | ТЗРЛ-200 |

| 600 | 9 | 4 | 10 | 5 |

| 750 | 11 | 5 | 10 | 6 |

| 800 | 11 | 6 | 8 | 7 |

| 1000 | 11 | 7 | 8 | 8 |

| 1200 | 13 | 8 | 9 | 9 |

| 1500 | 15 | 9 | 7 | 11 |

| 2000 | 17 | 11 | 8 | 13 |

1. * Значение номинальной предельной кратности вторичной обмотки приведено при номинальной вторичной нагрузке 30 ВА.

* Значение номинальной предельной кратности вторичной обмотки приведено при номинальной вторичной нагрузке 30 ВА.

2. Значение номинальной вторичной нагрузки уточняется в заказе.

3. Допускается кратковременное, не более двух часов в неделю, повышение значения номинального первичного тока на 20% по отношению к наибольшему рабочему первичному току.

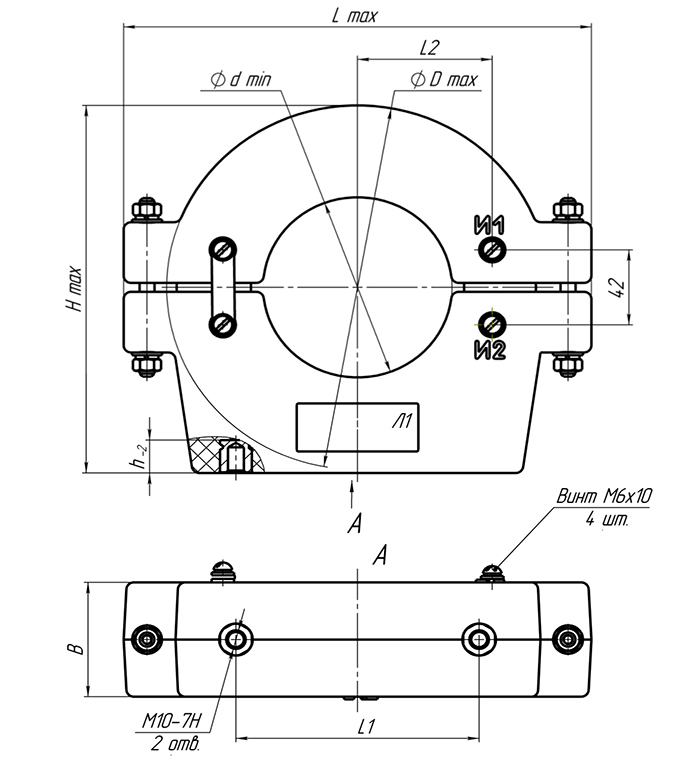

Габаритные размеры ТЗРЛ

| Тип трансформатора | Размеры, мм | Масса, кг | |||||||

| d | D | B | H | h | L | L1 | L2 | ||

| ТЗРЛ-70 | 70 | 170 | 85 | 172 | 14 | 213 | 100 | 60 | 8,4 |

| ТЗРЛ-100 | 100 | 204 | 64 | 206 | 17 | 250 | 125 | 72 | 7,3 |

| ТЗРЛ-125 | 125 | 225 | 80 | 228 | 17 | 270 | 125 | 85 | 9,2 |

| ТЗРЛ-150 | 150 | 255 | 85 | 260 | 16 | 300 | 180 | 97 | 12,0 |

| ТЗРЛ-180 | 180 | 290 | 85 | 295 | 17 | 335 | 180 | 115 | 14,6 |

| ТЗРЛ-200 | 205 | 316 | 60 | 325 | 22 | 360 | 180 | 127 | 12,5 |

Характеристики трансформатора ТЗЛМ-1

Быстрый запуск

Как это работает?

Тонкая настройка языковой модели с помощью PPO состоит примерно из трех шагов:

- Развертывание : языковая модель генерирует ответ или продолжение на основе запроса, который может быть началом предложения.

- Оценка : Запрос и ответ оцениваются с помощью функции, модели, обратной связи человека или некоторой их комбинации. Важно то, что этот процесс должен давать скалярное значение для каждой пары запрос/ответ. Оптимизация будет направлена на максимизацию этого значения.

- Оптимизация : Это самая сложная часть. На этапе оптимизации пары запрос/ответ используются для вычисления логарифмических вероятностей токенов в последовательностях. Это делается с помощью обученной модели и эталонной модели, которая обычно является предварительно обученной моделью перед тонкой настройкой. KL-расхождение между двумя выходными данными используется в качестве дополнительного сигнала вознаграждения, чтобы убедиться, что сгенерированные ответы не слишком сильно отклоняются от модели эталонного языка. Затем активная языковая модель обучается с помощью PPO.

Весь процесс показан на следующем рисунке:

Минимальный пример

Следующий код иллюстрирует описанные выше шаги.

# 0. импорт

импортный факел

из трансформеров импорт GPT2Tokenizer

из trl импортировать PPOTrainer, PPOConfig, AutoModelForCausalLMWithValueHead, create_reference_model

из trl.core импортировать response_to_batch

# 1. загрузить предварительно обученную модель

модель = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

model_ref = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

токенизатор = GPT2Tokenizer.from_pretrained('gpt2')

# 2. инициализировать трейнер

ppo_config = {'размер_пакета': 1}

конфигурация = PPOConfig(**ppo_config)

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор)

# 3. кодировать запрос

query_txt = "Сегодня утром я пошел в "

query_tensor = tokenizer.encode (query_txt, return_tensor = "pt")

# 4. генерировать ответ модели

response_tensor = response_to_batch (модель, query_tensor)

response_txt = tokenizer.decode (response_tensor [0,:])

# 5. определить вознаграждение за ответ

# (это может быть любая награда, например, отзывы людей или результаты другой модели)

награда = [torch. tensor (1.0)]

#6. модель поезда с ппо

train_stats = ppo_trainer.step([query_tensor[0]], [response_tensor[0]], вознаграждение)

tensor (1.0)]

#6. модель поезда с ппо

train_stats = ppo_trainer.step([query_tensor[0]], [response_tensor[0]], вознаграждение) Как правило, шаги 3–6 выполняются в цикле for для множества различных запросов. Вы можете найти более реалистичные примеры в разделе примеров.

Как использовать обученную модель

После обучения AutoModelForCausalLMWithValueHead вы можете напрямую использовать модель в преобразователях .

# .. Предположим, у нас есть обученная модель с использованием `PPOTrainer` и `AutoModelForCausalLMWithValueHead`

# запихнуть модель в хаб

model.push_to_hub («моя точно настроенная модель-ppo»)

# или сохранить локально

model.save_pretrained («моя точно настроенная модель-ppo»)

# загружаем модель из хаба

из трансформаторов импорт AutoModelForCausalLM

модель = AutoModelForCausalLM.from_pretrained("моя точно настроенная модель-ppo") Вы также можете загрузить свою модель с AutoModelForCausalLMWithValueHead , если вы хотите использовать головку значений, например, для продолжения обучения.

из импорта trl.model AutoModelForCausalLMWithValueHead

model = AutoModelForCausalLMWithValueHead.from_pretrained("my-fine-tuned-model-ppo") Настройка обучения

В trl мы предоставляем возможность предоставить пользователям достаточную модульность, чтобы иметь возможность эффективно настраивать цикл обучения в соответствии со своими потребностями. . Ниже приведены несколько примеров того, как вы можете применять и тестировать различные методы.

Используйте разные оптимизаторы

По умолчанию PPOTrainer создает оптимизатор torch.optim.Adam . Вы можете создать и определить другой оптимизатор и передать его в PPOTrainer :

импортный факел

из трансформеров импорт GPT2Tokenizer

из trl импортировать PPOTrainer, PPOConfig, AutoModelForCausalLMWithValueHead

# 1. загрузить предварительно обученную модель

модель = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

model_ref = AutoModelForCausalLMWithValueHead. from_pretrained('gpt2')

токенизатор = GPT2Tokenizer.from_pretrained('gpt2')

# 2. определить конфиг

ppo_config = {'batch_size': 1, 'learning_rate': 1e-5}

конфигурация = PPOConfig(**ppo_config)

# 2. Создать оптимизатор

оптимизатор = torch.optim.SGD(model.parameters(), lr=config.learning_rate)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор)

from_pretrained('gpt2')

токенизатор = GPT2Tokenizer.from_pretrained('gpt2')

# 2. определить конфиг

ppo_config = {'batch_size': 1, 'learning_rate': 1e-5}

конфигурация = PPOConfig(**ppo_config)

# 2. Создать оптимизатор

оптимизатор = torch.optim.SGD(model.parameters(), lr=config.learning_rate)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор) Для эффективной тонкой настройки памяти вы также можете передать оптимизатор Adam8bit из бит и байтов :

импортировать факел

импортировать биты и байты как bnb

из трансформеров импорт GPT2Tokenizer

из trl импортировать PPOTrainer, PPOConfig, AutoModelForCausalLMWithValueHead

# 1. загрузить предварительно обученную модель

модель = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

model_ref = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

токенизатор = GPT2Tokenizer.from_pretrained('gpt2')

# 2. определить конфиг

ppo_config = {'batch_size': 1, 'learning_rate': 1e-5}

конфигурация = PPOConfig(**ppo_config)

# 2. Создать оптимизатор

оптимизатор = bnb.optim.Adam8bit(model.parameters(), lr=config.learning_rate)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор)

Создать оптимизатор

оптимизатор = bnb.optim.Adam8bit(model.parameters(), lr=config.learning_rate)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор) Используйте оптимизатор LION

Вы также можете использовать новый оптимизатор LION от Google. Сначала возьмите здесь исходный код определения оптимизатора и скопируйте его, чтобы импортировать оптимизатор. Обязательно инициализируйте оптимизатор, рассматривая обучаемые параметры только для более эффективного обучения с использованием памяти: ) … ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор)

Мы советуем вам использовать скорость обучения, которую вы использовали бы для Адама , разделенную на 3, как указано здесь. Мы заметили улучшение при использовании этого оптимизатора по сравнению с классическим Адамом (проверьте полные журналы здесь):

Добавить планировщик скорости обучения

Вы также можете поиграть со своими тренировками, добавив планировщики скорости обучения!

импортная горелка из трансформеров импорт GPT2Tokenizer из trl импортировать PPOTrainer, PPOConfig, AutoModelForCausalLMWithValueHead # 1.загрузить предварительно обученную модель модель = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2') model_ref = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2') токенизатор = GPT2Tokenizer.from_pretrained('gpt2') # 2. определить конфиг ppo_config = {'batch_size': 1, 'learning_rate': 1e-5} конфигурация = PPOConfig(**ppo_config) # 2. Создать оптимизатор оптимизатор = torch.optim.SGD(model.parameters(), lr=config.learning_rate) lr_scheduler = lr_scheduler = torch.optim.lr_scheduler.ExponentialLR(оптимизатор, гамма=0,9) # 3. инициализировать трейнер ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор, lr_scheduler = lr_scheduler)

Эффективная точная настройка памяти за счет совместного использования слоев

Еще один инструмент, который вы можете использовать для более эффективной тонкой настройки памяти, — совместное использование слоев между эталонной моделью и моделью, которую вы хотите обучить.

импортная горелка из трансформеров импорт AutoTokenizer из trl импортировать PPOTrainer, PPOConfig, AutoModelForCausalLMWithValueHead, create_reference_model # 1.загрузить предварительно обученную модель модель = AutoModelForCausalLMWithValueHead.from_pretrained('bigscience/bloom-560m') model_ref = create_reference_model (модель, num_shared_layers = 6) tokenizer = AutoTokenizer.from_pretrained('bigscience/bloom-560m') # 2. инициализировать трейнер ppo_config = {'размер_пакета': 1} конфигурация = PPOConfig(**ppo_config) ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор)

Передайте 8-битные эталонные модели

Поскольку trl поддерживает все аргументы ключевых слов при загрузке модели из преобразователей с использованием from_pretrained , вы также можете использовать load_in_8bit из преобразователей для более эффективной тонкой настройки памяти.

Подробнее о загрузке 8-битной модели в преобразователи читайте здесь.

# 0. импорт # pip установить битсандбайты импортный факел из трансформеров импорт AutoTokenizer из trl импортировать PPOTrainer, PPOConfig, AutoModelForCausalLMWithValueHead # 1.

tensor (1.0)]

#6. модель поезда с ппо

train_stats = ppo_trainer.step([query_tensor[0]], [response_tensor[0]], вознаграждение)

tensor (1.0)]

#6. модель поезда с ппо

train_stats = ppo_trainer.step([query_tensor[0]], [response_tensor[0]], вознаграждение)  from_pretrained('gpt2')

токенизатор = GPT2Tokenizer.from_pretrained('gpt2')

# 2. определить конфиг

ppo_config = {'batch_size': 1, 'learning_rate': 1e-5}

конфигурация = PPOConfig(**ppo_config)

# 2. Создать оптимизатор

оптимизатор = torch.optim.SGD(model.parameters(), lr=config.learning_rate)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор)

from_pretrained('gpt2')

токенизатор = GPT2Tokenizer.from_pretrained('gpt2')

# 2. определить конфиг

ppo_config = {'batch_size': 1, 'learning_rate': 1e-5}

конфигурация = PPOConfig(**ppo_config)

# 2. Создать оптимизатор

оптимизатор = torch.optim.SGD(model.parameters(), lr=config.learning_rate)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор)  Создать оптимизатор

оптимизатор = bnb.optim.Adam8bit(model.parameters(), lr=config.learning_rate)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор)

Создать оптимизатор

оптимизатор = bnb.optim.Adam8bit(model.parameters(), lr=config.learning_rate)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор)  загрузить предварительно обученную модель

модель = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

model_ref = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

токенизатор = GPT2Tokenizer.from_pretrained('gpt2')

# 2. определить конфиг

ppo_config = {'batch_size': 1, 'learning_rate': 1e-5}

конфигурация = PPOConfig(**ppo_config)

# 2. Создать оптимизатор

оптимизатор = torch.optim.SGD(model.parameters(), lr=config.learning_rate)

lr_scheduler = lr_scheduler = torch.optim.lr_scheduler.ExponentialLR(оптимизатор, гамма=0,9)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор, lr_scheduler = lr_scheduler)

загрузить предварительно обученную модель

модель = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

model_ref = AutoModelForCausalLMWithValueHead.from_pretrained('gpt2')

токенизатор = GPT2Tokenizer.from_pretrained('gpt2')

# 2. определить конфиг

ppo_config = {'batch_size': 1, 'learning_rate': 1e-5}

конфигурация = PPOConfig(**ppo_config)

# 2. Создать оптимизатор

оптимизатор = torch.optim.SGD(model.parameters(), lr=config.learning_rate)

lr_scheduler = lr_scheduler = torch.optim.lr_scheduler.ExponentialLR(оптимизатор, гамма=0,9)

# 3. инициализировать трейнер

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор, оптимизатор = оптимизатор, lr_scheduler = lr_scheduler)  загрузить предварительно обученную модель

модель = AutoModelForCausalLMWithValueHead.from_pretrained('bigscience/bloom-560m')

model_ref = create_reference_model (модель, num_shared_layers = 6)

tokenizer = AutoTokenizer.from_pretrained('bigscience/bloom-560m')

# 2. инициализировать трейнер

ppo_config = {'размер_пакета': 1}

конфигурация = PPOConfig(**ppo_config)

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор)

загрузить предварительно обученную модель

модель = AutoModelForCausalLMWithValueHead.from_pretrained('bigscience/bloom-560m')

model_ref = create_reference_model (модель, num_shared_layers = 6)

tokenizer = AutoTokenizer.from_pretrained('bigscience/bloom-560m')

# 2. инициализировать трейнер

ppo_config = {'размер_пакета': 1}

конфигурация = PPOConfig(**ppo_config)

ppo_trainer = PPOTrainer (конфигурация, модель, model_ref, токенизатор)